Решение задачи охлаждения высоконагруженных серверных стоек

При построении современного центра обработки данных (ЦОД), у которого стоимость одного квадратного метра может доходить до нескольких десятков тысяч долларов, очень важное условие — максимальная загрузка занимаемой площади.

Решая такую непростую задачу владелец ЦОД приходит к мысли о необходимости более плотного размещения ИТ оборудования. Здесь важно учитывать одну очень непростую проблему, связанную с отводом большого количества тепла от каждой максимально заполненной стойки, которое будет выделяться в ходе работы аппаратуры.

В качестве примера расчета количества выделяемого тепла можно взять решения компаний IBM и DELL:

Решение от компании IBM

-

Каждое шасси BladeCenter имеет размер «7U»

-

В стандартную стойку 42U высотой можно установить максимально 6шт BladeCenters

-

Максимальное тепловыделение одного BladeCenter составляет 4kW

-

Максимальное тепловыделение полностью загруженной стойки будет составлять суммарно 24kW

-

Требуемый охлаждающий воздушный поток на один BladeCenter 850 м3/час

-

Суммарный охлаждающий воздушный поток на одну серверную стойку: 6 x 850 = 5100 м3/час

-

Схема движения воздуха: с фронта назад

Решение от компании Dell

-

10 шт PowerEdge 1855 Blades занимают 7U в серверной стойке

-

Максимально можно установить 60шт PowerEdge 1855 Blades в одну серверную стойку 42U высотой

-

Максимальное тепловыделение 10шт Blades составляет 4.17kW

-

Максимальное тепловыделение 60 штук PowerEdge 1855 Blades , установленных в одну серверную стойки будет составлять 25 kW

-

Номинальный охлаждающий воздушный поток на один PowerEdge 1855 Blades составляет 68 м3/час

-

Суммарно охлаждающий воздушный поток на одну серверную стойку с 60-тью PowerEdge 1855 Blades составит: 6 x 680 = 4080 м3/час

-

Схема движения воздуха: с фронта назад

Получается, что полностью загруженная стойка требует охлаждающего воздушного потока от 4000 до 5000 м3/час.

Чтобы подать такой воздушный поток, нужно установить перед серверной стойкой как минимум три решетки 600 Х 600 мм! Тогда перед каждой серверной стойкой в дата-центре должно быть не менее 1,8 метра, а если ряды стоек будут размещены лицом друг к другу, то проход между стойками будет шириной 3,6 метра, что ведет к неэффективному использования пространства в компьютерном зале центра обработки данных.

Скорее всего, количество выделяемого тепла будет меньше расчетного, так как все серверы в стойке одновременно не загружаются на 100%. Однако, не надо забывать, что с учетом использования виртуализации в ЦОД загрузка серверов будет увеличиваться и приближаться к 90% и даже больше 90 процентов. Но даже если взять за основу цифру в 15 кВт (нагрузка стойки, о которой заявляют производители серверов), то все равно она достаточно высокая, и необходимо применять какие-то специализированные решения, которые могли бы обеспечить надлежащий уровень охлаждения без перегрева установленного в стойку оборудования.

Мы рассмотрим в данной статье несколько стандартных подходов к воздушному охлаждению в ЦОД и посмотрим, как можно решить задачу охлаждения серверной стойки с выделением тепла до 15 кВт и даже до 25 кВт, не прибегая к системе охлаждения с использованием жидких хладагентов.

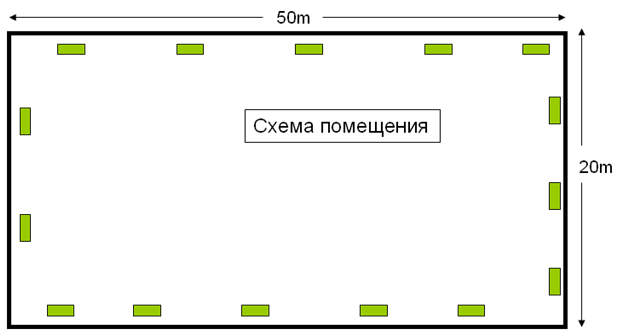

Пример дата-центра с тепловой нагрузкой менее 2 кВт на один квадратный метр

В качестве исходных данных рассмотрим следующий пример

|

Площадь серверного зала |

1000 м² |

|

Тепловая нагрузка: |

1 кВт/м² |

|

Схема охлаждения: |

Кондиционеры с подачей воздуха установлены по периметру помещения и показаны зелеными прямоугольниками на рисунке ниже |

|

Схема резервирования |

n+2 |

|

Количество кондиционеров: |

15 x 80 кВт |

Типовое распределение холодного воздуха для решения поставленной задачи в ЦОД будет следующим:

|

Высота фальшпола: |

от 0,6 до 1,0 метра |

|

Высота потолков: |

от 3 до 5 метров выше уровня фальшпола |

|

Высота серверных стоек: |

от 2 до 2.4 метров |

При увеличении нагрузки на серверную стойку такая схема уже не подойдет, так как будут возникать следующие проблемы:

-

Подача воздуха через пол ограничена

-

Мощность охлаждения ограничена

-

Дополнительный нагрев от другого оборудования

Переход к оценке тепловыделения в одной серверной стойке

При возрастающих нагрузках в современных дата-центрах необходимо переходить к оценке и расчету тепловых нагрузок на серверную стойку, что позволяет более точно оценить и рассчитать систему охлаждения в ЦОД.

Также требуются другие подходы к размещению оборудования и распределению воздушных потоков в серверном зале.

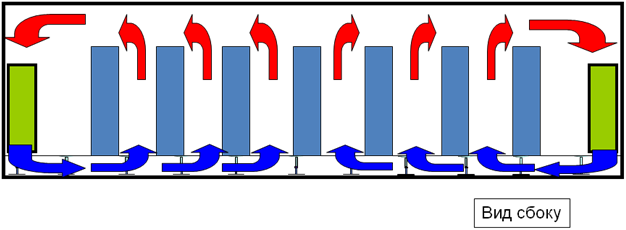

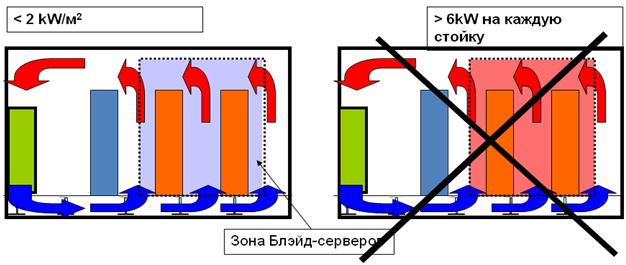

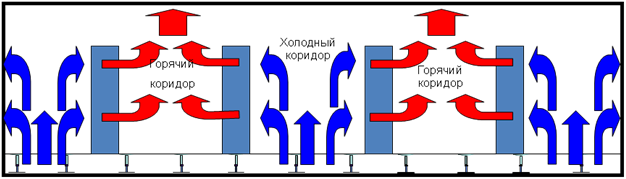

Система с «горячими» и «холодными» коридорами позволяет повысить нагрузку на серверную стойку до 6 кВт

При нагрузке от 3 кВт до 6 кВт в ЦОДе требуется уже создать систему охлаждения с «холодными» и «горячими» коридорами. Холодный воздух попадает через решетки в фальшполе и подается спереди на серверные стойки. Два ряда серверных стоек устанавливаются лицом друг к другу и образуют зону подачи холодного воздуха – «холодный» коридор. Горячий воздух выходит сзади серверных стоек в коридор, который образует зону с горячим воздухом – «горячий» коридор.

К сожалению, данное решение уже не решает проблемы еще более плотного расположения серверов и выделения тепла свыше 5-6 кВт на одну стойку.

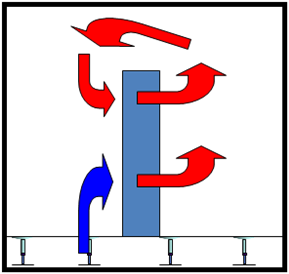

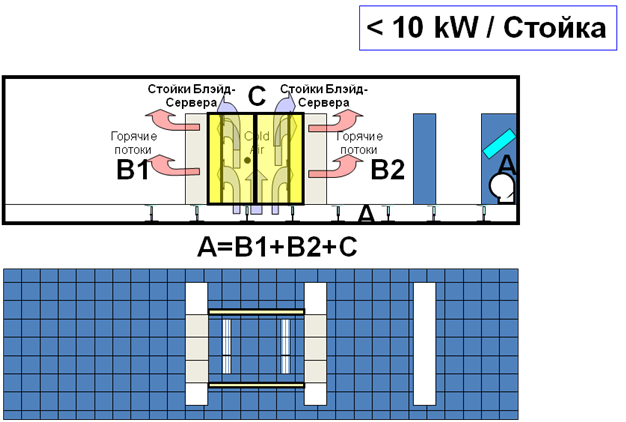

Создание «холодного бассейна» и повышение отвода тепла до 10-15 кВт со стойки

При выходе воздушного потока сзади серверных стоек возникает ситуация, когда часть горячего потока поступает в зону холодного воздуха и начинает там смешиваться, повышая температуру на входе в оборудования и снижая эффективность системы. При росте нагрузки свыше 5 кВт необходимо изолировать «холодные» и «горячие» коридоры. Тем самым поднимается КПД системы охлаждения дата центра и, как результат, снижаются эксплуатационные расходы. Стойки забирают холодный воздух спереди и выпускают нагретый воздух сзади, который уже не смешивается с холодным. При таком решении можно обеспечить охлаждение на каждую серверную стойку до 10 кВт. На рисунке ниже показан пример создания «холодного бассейна».

Преимущества «холодного бассейна»

-

Простое решение

-

Использование стандартных кондиционеров

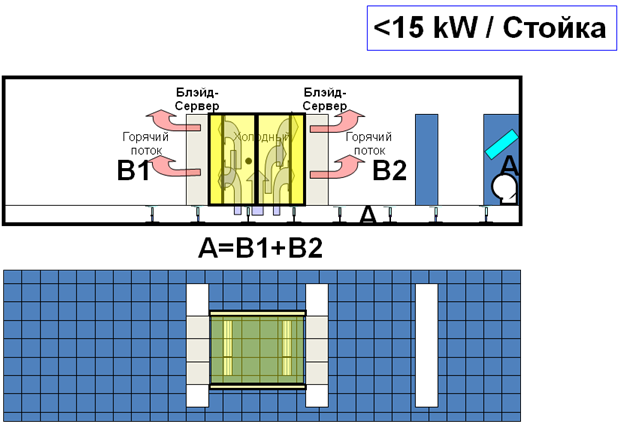

При повышении нагрузки до 15 кВт добавляется верхняя перегородка в «холодном» коридоре, тем самым полностью его изолируя.

Фотография центра обработки данных с использованием «холодного бассейна»

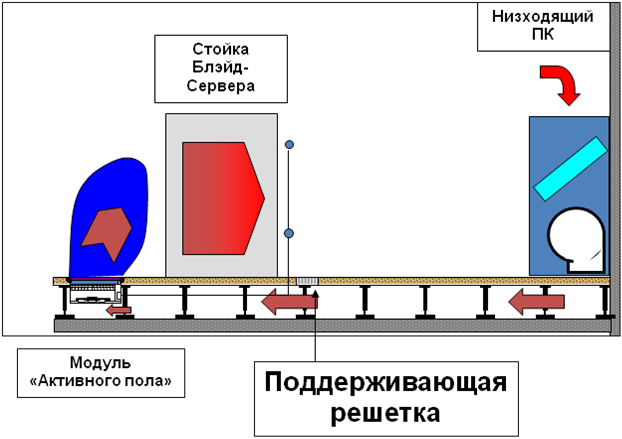

Решение с использованием «активного пола»

Но что делать, если необходимо отводить свыше 10-15 кВт от каждой серверной стойки и при этом не увеличивать количество решеток в «холодном» коридоре? Отсюда возникает вопрос: как подать достаточный поток воздуха через то же количество решеток, чтобы серверы получили «свою порцию» холодного воздуха?

Предлагается использовать решение итальянской фирмы Uniflair — «активный пол». Основной идеей охлаждения при помощи «активного пола» является подача гораздо большего регулируемого потока воздуха (до 4500 м3/час вместо 800-1000 м3/час от обычной решетки 600 Х 600 мм).

Установить просто вентилятор в подпольном пространстве было бы не достаточно для обеспечения гарантированного охлаждения серверных стоек. Важно правильно организовать воздушный поток как по давлению, так и по направлению воздуха, чтобы обеспечить подачу воздуха не только в верхнюю часть стойки, но и, в случае необходимости, обеспечить подачу холодного воздуха в ее нижнюю часть. Для этого панель «активного пола» помимо вентилятора, комплектуется процессором, датчиками температуры и поворотными ламелями. Важной особенностью этого изделия, является большой ресурс работы.

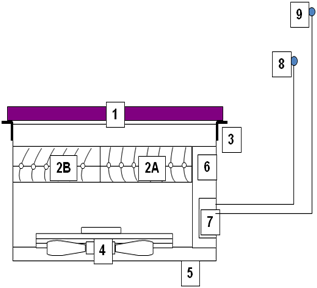

Устройство панели «активного пола»

1 Решетка

2а Регулируемые лопасти – Зона А

2b Регулируемые лопасти – Зона B

3 Фиксирующие скобы

4 EC вентилятор

5 Решетка подмеса воздуха

6 Электропанель

7 Контроллер

8 Датчик температуры – Зона A

9 Датчик температуры – Зона B

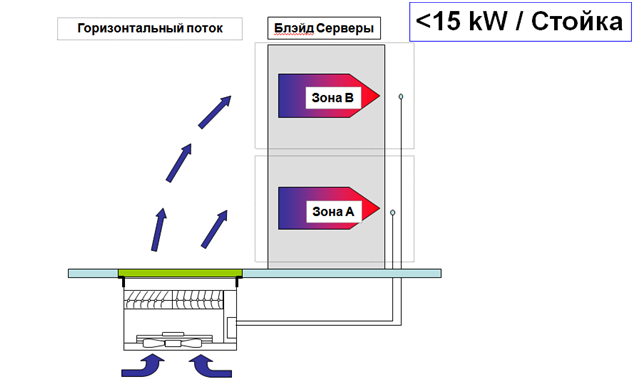

Ниже на картинке приводятся примеры исполнения «активного пола» для горизонтального и вертикального потоков, которые распределяется на две зоны.

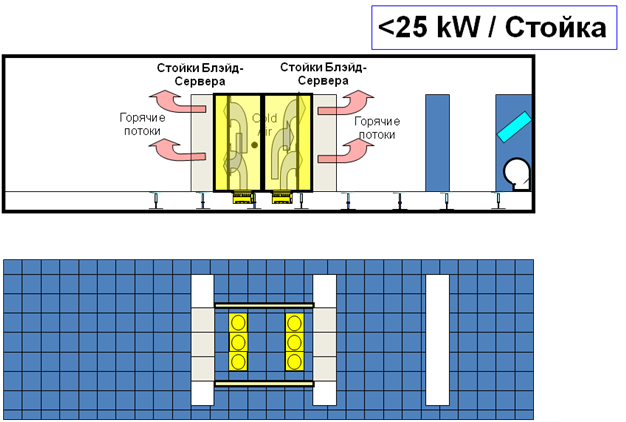

Схемы решений на базе «активного пола» до 15 кВт на стойку и до 25 кВт на стойку

Применение системы «активный пол» позволяет повысить мощность тепловыделения стойки до 25 кВт!

Ниже показан пример решения с «активным полом» и «холодным бассейном».

Преимущества решения на базе «активный пол»

У любого решения есть свои плюсы и минусы. Ниже перечислим основные преимущества и недостатки «активного пола».

-

Модульная система легко устанавливается в стандартный фальшпол дата-центра

-

Поток воздуха позволяет использовать стойку в полной мощности

-

Не требуется подача воды или фреона в зону серверных стоек

-

Минимальный поток гарантирован даже в случае поломки вентилятора

-

Подходит для расширения существующих серверных и компьютерных залов

-

Возможно локальное использование при наличии только одной или нескольких высоконагруженных стоек

-

Быстрый эффект от использования данного решения

-

Энергосбережение

-

Возможность управления

Недостатки

-

Мощные потоки воздуха в подпольном пространстве

Заключение

Можно составить схему поэтапного развития и модернизации дата-центра, состоящего из трех этапов:

-

При проектировании дата-центра на первом этапе можно ограничиться расстановкой оборудования с организацией «холодных» и «горячих» коридоров.

-

По мере роста нагрузки и мощности на втором этапе следует организовать «холодный бассейн» с полной изоляцией «холодного» коридора.

-

Если потребуется большая мощность охлаждения, то необходимо установить «активный пол» в местах с максимальной нагрузкой серверных стоек.

Естественно, что дата-центр должен иметь достаточную мощность охлаждения прецизионными кондиционерами на всех этапах своего развития.

Данная статья написана специалистами фирмы ООО «ЮНИКОНД» с использованием материалов фирмы Uniflair.

Компания ООО «ЮНИКОНД» занимается проектированием, поставкой, монтажом систем охлаждения и кондиционирования дата-центров на базе оборудования фирмы Uniflair. Фирма берет на себя наладку и ремонт кондиционеров Вашего действующего центра обработки данных, проводим необходимое техническое обслуживание и поддержку.

Контакты компании «ЮНИКОНД»

и

т./ф. (495) 664-29-59

Сообщения, вопросы и ответы

Вы можете задать вопрос, написать комментарий, обсудить данную новость или статью.

Сергей Волков 04.04.2010 в 21:02

Анатолий, здравствуйте,

Спасибо за интересную статью.

Решение очень интересное, но напрягает следующий момент.

Действительно ли можно довести охлаждение серверной стойки до 25 кВт или хотя бы до 20 кВт.

Есть ли уже готовые решения в России?

C Уважением, Сергей.

Анатолий 21.04.2010 в 09:34

Уважаемый Сергей!

У нас уже есть подобные проекты, причем в части из них мы монтировали «активный пол» в действующие ЦОДы, где

стоят кондиционеры других брендов.

спасибо.

Юрий 22.07.2015 в 10:37

(подписан на сообщения)Здравствуйте у нас идет монтаж большого серверного помещенияю

35*18 м размер помещения

4 м высота

окон нету

фальш пола нету

будет стоять 150 стоек 42U

заказчик дает нам тепловыделение одной стойки 30кВт

Каким оборудованием можно добиться нужного результата

И какая нужна мощность охлаждения?

За ранее спасибо!

Дмитрий 05.08.2015 в 14:27

Юрий,

Вопрос очень непростой и чтобы ответить на него правильно, надо пообщаться с заказчиком и понять для каких задач он строит ЦОД, как он планирует заполнять и чем стойки и зал — слишком странный запрос 150 стоек по 30 кВт

Так будет ответ пальцем в небо

Коротко

Если не разговаривать с заказчиком, а тупо взять 150 *30 и скажем примем, что они загружены будут максимум на 50 процентов одновременно, то получиться по холоду 2,25 МВт

Рекомендую посетить семинар 26-28 августа, там мы рассматриваем построение систем охлаждения с использованием различных схем.

Без общения с заказчиком опять же по оборудованию будет тык пальцем в небо.

Денис 28.09.2016 в 23:27

(подписан на сообщения)Анатолий, день добрый. Прошу предложить решение для маленького ЦОД площадью 6 кв.м. Плаируемая мощность серверов 40 кВт.