Влияние температуры в центрах обработки данных на надежность и эффективность. Часть 1

Энергия, потребляемая центрами обработки данных (ЦОД), начинает составлять значительную долю мирового энергопотребления и выбросов углекислого газа. Большая часть потребляемой энергии расходуется на охлаждение дата-центра, что стало причиной большого числа исследований в области управления температурой в дата-центрах. Интересно, что главный аспект управления температурой не был хорошо понят: регулирование заданного значения температуры, при которой должна работать система охлаждения дата-центра. В большинстве дата-центров термостаты настраиваются, исходя из консервативных рекомендаций производителей, что объясняется ограниченными данными о влиянии более высоких температур на систему. В то же время, по результатам исследований, повышение заданного значения температуры всего лишь на один градус могло бы сократить потребление энергии на 2–5%.

В этой работе дается всесторонний анализ управления температурой в дата-центрах. Мы использовали большую совокупность данных полевых наблюдений в разных производственных средах для изучения воздействия температуры на надежность оборудования, включая надежность подсистемы хранения данных, подсистемы памяти и надежность сервера в целом. Мы также использовали экспериментальный испытательный стенд с термокамерой, и большое число эталонов (критериев) для изучения двух других потенциальных проблем более высоких температур в дата-центрах: воздействие на производительность и электропотребление сервера. Основываясь на полученных данных, мы даем рекомендации по управлению температурой в дата-центрах, которые дают возможность экономии энергии, и в то же время позволяют ограничивать отрицательные воздействия на надежность и производительность системы.

1. ВВЕДЕНИЕ

Центры обработки данных становятся большими потребителями электроэнергии. По некоторым оценкам, дата-центры расходуют столько электроэнергии, сколько вырабатывают приблизительно семнадцать электростанций мощностью 1,000 МВ, что составляет более 1% мирового потребления электроэнергии, и выбрасывают столько же углекислого газа, сколько вся Аргентина [17]. Более трети, а иногда почти половину счетов за электроэнергию в дата-центрах составляет электроэнергия, расходуемая на их охлаждение [6, 19]. Например, в дата-центре площадью 30,000 квадратных футов (около 2787 м2) и мощностью 10 МВ, ежегодные расходы на эксплуатацию охлаждающей инфраструктуры могут достигать 4-8 миллионов долларов [23].

Не удивительно, что большая часть исследований посвящена сокращению затрат на охлаждение. В число изучавшихся подходов (технологий) входят, например, методы повышения эффективности (распределения) воздуха [23, 35], равномерное распределение нагрузки, учет температуры при размещении оборудования в дата-центрах [7, 25, 28, 33], и включение функций снижения электропотребления в индивидуальные серверы [14, 15].

Примечательно, что один из главных аспектов управления температурой в дата-центрах все еще недостаточно изучен: регулирование заданного значения температуры, при которой должна работать система охлаждения дата-центра. Как правило, дата-центры работают при температуре 20-22°C, в некоторых из них температура может опускаться до 13 градусов Цельсия [8, 29]. Из-за недостаточного количества научных данных, выбор этих значений часто основывается на консервативных рекомендациях производителей оборудования. По некоторым данным, повышение заданного значения температуры всего лишь на один градус позволяет сокращать энергопотребление на 2-5% [8, 9].

По сообщениям компании Майкрософт, повышение температуры на 2-4 градуса в одном из ее дата-центров в Силиконовой долине позволило сэкономить 250000 долларов в год на энергетических затратах [29]. Google and Facebook также рассматривали возможности повышения температуры в своих дата-центрах [29].

В то время как повышение температуры в дата-центрах могло бы казаться простым способом экономии энергии и снижения выбросов углекислого газа, оно может представлять и некоторые проблемы, при этом наиболее заметной из них является воздействие повышения температуры на надежность системы. К сожалению, проблема влияния повышения температуры в дата-центре на надежность оборудования еще не достаточно изучена, а имеющиеся сведения являются противоречивыми. Результаты недавнего исследования [35] показали, что для того чтобы избежать «зашкаливания» температуры, температура воздуха на передних впускных отверстиях стандартного сервера должна быть 20–30°C. При увеличении температуры на 10°C выше 21°C надежность электронных устройств с длительным сроком эксплуатации уменьшается на 50% [24]. По результатам других исследований, повышение температуры на 15°C увеличивает частоту отказов жесткого диска в два раза [4, 10]. С другой стороны, недавнее исследование Google [26] показало, что в действительности на надежность сильнее влияют более низкие температуры, чем более высокие температуры.

Другие возможные проблемы повышения температуры в центрах обработки данных включают следующие моменты: воздействие на производительность серверов, так как в большинстве серверов используются такие приемы как регулирование производительности работы CPU или производительности памяти при достижении температурой критического порогового значения; увеличение потребления электроэнергии серверами, так как повышение температуры будет приводить к дополнительной утечке электричества и увеличению частоты вращения встроенных в сервера вентиляторов.

Целью этой работы является разъяснение проблем, связанных с повышением температуры в ЦОД. Для начала, в разделе 2 подробно рассматривается воздействие температуры на надежность оборудования на основе анализа большого числа данных полевых наблюдений. Данные для исследования предоставлены тремя разными организациями с нескольких десятков дата-центров и охватывают различные проблемы надежности, включая: отказы жестких дисков; ошибки скрытых секторов жестких дисков; фатальные неисправимые ошибки DRAM; замена DRAM, и общие перебои в работе узлов. В разделе 3 выполняется экспериментальное исследование с использованием оборудованного термокамерой испытательного стенда и большого комплекта разных рабочих нагрузок для улучшения понимания влияния температуры на производительность и электропотребление компьютерных систем. Наконец, в разделе 4 полученные в ходе исследования результаты используются для выведения некоторых соображений и рекомендаций по эксплуатации дата-центров в условиях более высоких температур, и в то же время ограничению воздействия на производительность и надежность систем.

Раздел 2. ТЕМПЕРАТУРА И НАДЕЖНОСТЬ

Исследование начинается с анализа различных наборов данных полевых наблюдений, собранных в разных организациях и центрах обработки данных, с целью улучшения понимания воздействия температуры на разнообразные аспекты надежной работы оборудования. Исследование сосредоточено на двух специфичных аппаратных компонентах (жестких дисках и памяти DRAM), поскольку замена этих компонентов чаще всего выполняется в современных дата-центрах [30, 31]. В параграфах 2.1 и 2.2 рассматриваются два общераспространенных вида отказов жестких дисков, ошибки скрытых секторов и полные отказы дисков, соответственно, а в параграфе 2.3 дается описание проблем надежности DRAM. Затем в параграфе 2.4 данные по отключению электропитания узлов в дата-центрах используются для изучения воздействия температуры на общую надежность серверов.

2.1 Температура и ошибки скрытых секторов

2.1.1 Освещение проблемы и исходные данные

Ошибки скрытых секторов (LSE) представляют собой общераспространенный вид отказа, при котором индивидуальные секторы на диске становятся недоступными, а хранящиеся в них данные теряются, если система не может использовать механизмы резервирования для их восстановления. Ошибки LSE происходят с высокой частотой в полевых условиях [5, 26], при этом они происходят на 3-4% всех жестких дисков в определенный момент их эксплуатации, и, по прогнозам, их число может только расти вместе с увеличением емкости диска. Хотя в недавнем исследовании [5] изучались распространенность и статистические свойства ошибок LSE, но там не было исследования по воздействию температуры на ошибки.

Для изучения воздействия температуры на распространенность ошибок LSE мы получили данные, собранные в разных дата центрах компании Google в период с января 2007 г. по май 2009 г., которые охватывают три разных модели дисков. По каждому из дисков составлялись ежемесячные отчеты, содержащие данные по средней внутренней температуре диска и колебаниям температуры в течение данного месяца, числу ошибок скрытых секторов, числу операций чтения и записи в течение данного месяца, а также периоду эксплуатации диска.

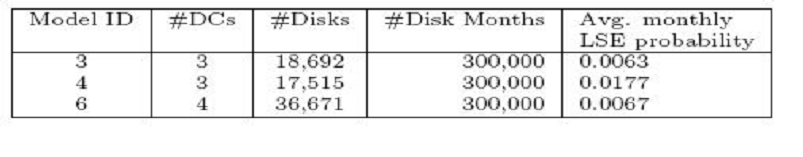

Все данные собирались методом опроса встроенной системы самоконтроля дисков (технология SMART). Инфраструктура и методология измерений, которые использовались Google для сбора подобных данных, описаны в Pinheiro et al. [26]. В приведенной ниже таблице дается общее представление этих данных:

2.1.2 Анализ

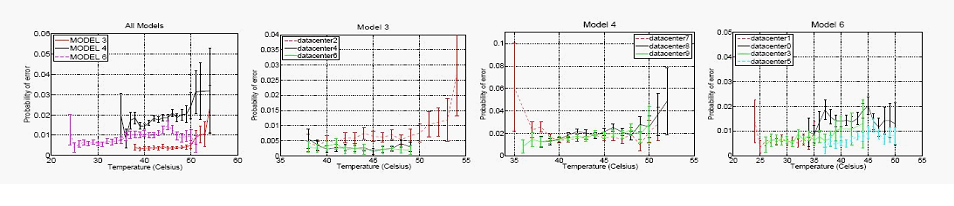

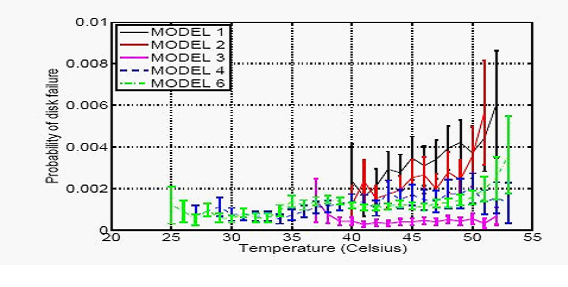

На рисунке 1 в крайнем левом углу показана зависимость ежемесячной вероятности возникновения ошибки LSE на дисках каждой из трех моделей как функции средней температуры. «Усы» ошибки на этом рисунке и на всех остальных рисунках в этой работе вычислялись с уровнем достоверности 95%; большие «усы» для более высоких температур объясняются недостаточностью данных. Поскольку в дата-центрах, помимо температуры, может быть много других специфических факторов, которые влияют на надежность (рабочая нагрузка, относительная влажность, всплески электропотребления, процедуры обработки, и т.п.), результаты каждой модели делятся по дата-центрам. На трех правых графиках рисунка 1 показана вероятность возникновения LSE в данном месяце в этих трех моделях, при этом каждая линия соответствует разным дата-центрам.

Рисунок 1. Вероятность возникновения ошибок LSE в течение месяца как функция температуры. В этих трех моделях каждая линия соответствует разным дата-центрам.

Как можно было ожидать, наблюдалась тенденция повышения частоты появления ошибок LSE при повышении температуры. Однако, величина повышения оказалась намного меньше ожидавшегося значения, основанного на общих моделях и расчетах, в частности, при разделении случаев возникновения ошибок LSE на модель на дата-центр. Обычно в моделях воздействия температуры на аппаратные компоненты допускается экспоненциальный рост отказов вместе с ростом температуры на основе уравнения Аррениуса [16], и прогнозируется почти двойное увеличение частоты отказов при увеличении температуры на 10-15°C [4, 10, 35]. Визуально графики показывают, что только в 5 из 10 комбинаций моделей и дата-центров заметно явное увеличение числа ошибок вместе с ростом температуры: модель 3, дата-центр 2; модель 4, дата-центры 8 и 9; модель 6, дата-центры 3 и 5. Было также замечено, что увеличение частоты ошибок имеет скорее линейный, чем экспоненциальный характер, за исключением очень высоких температур (выше 50°C).

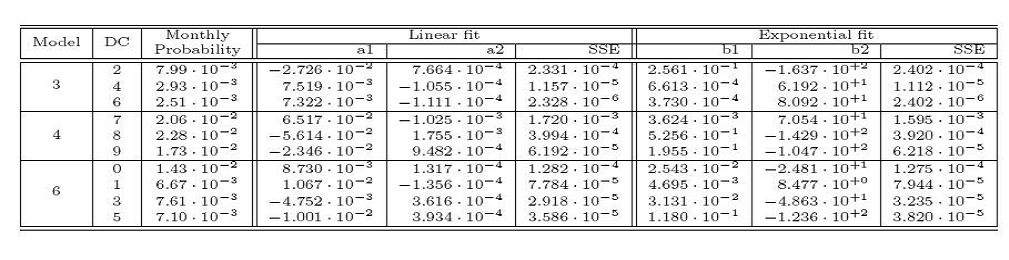

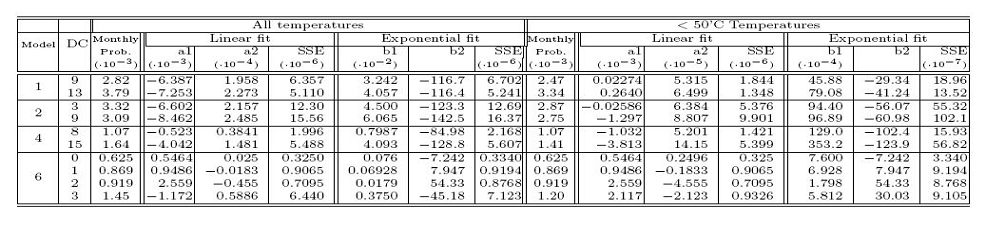

Таблица 1: Параметры приближения линейных и экспоненциальных моделей помесячного роста вероятности ошибок LSE в зависимости от средней температуры.

Для формального представления упоминавшегося выше наблюдения данные обрабатывались с использованием двух разных моделей. Первой является простая линейная модель, т.e., мы пытались моделировать частоту ошибок 'y' в зависимости от температуры 't', где y = a1 + a2*t. Поскольку одной из самых распространенных моделей воздействия температуры на надежность оборудования, модель или уравнение Аррениуса, является экспоненциальной, мы также применяли экспоненциальную модель к своим данным, т.e., мы моделировали частоту отказов в зависимости от температуры 't', где: y = a1 e−a2/t. Подробные результаты (включая значения параметров a1, a2, b1, b2, а также соответствующая сумма квадратов ошибок (SSE)), представлены в Таблице 1. Мы узнали, что во всех случаях линейная модель дает приближение сопоставимой или даже лучшей точности, при измерении с помощью SSE. Единственным исключением является модель 3, дата-центр 2, где экспоненциальная модель дает лучшее приближение. Мы объясняем это резким увеличением ошибок LSE при температурах выше 50°C. При повторении своего анализа только для точек измерения с температурой ниже 50°C, также для модели 3 и дата-центра 2, линейная модель частоты возникновения ошибок в зависимости от температуры дает лучшее приближение.

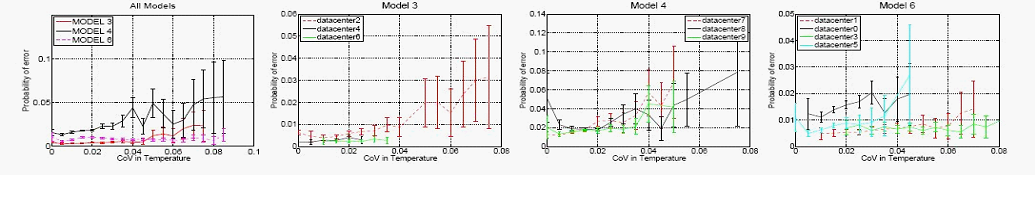

Рис. 2: Помесячная вероятность возникновения ошибок LSE в зависимости от колебаний температуры, измеренных с использованием коэффициента изменения. На трех графиках индивидуальных моделей каждая линия соответствует измерению из другого дата-центра.

Вывод 1: Для температурного диапазона, который наши данные включают в области статистической достоверности (< 50°C), распространенность ошибок скрытых секторов увеличивается намного медленнее с температурой, чем это предполагается моделями расчета надежности с учетом экспоненциального роста возникновения ошибок при росте температуры. В половине пар моделей дисков и дата-центров не видно никаких признаков увеличения, а в остальных парах это увеличение носит линейный, а не экспоненциальный характер.

В дополнение к сравнению качества линейного и экспоненциального приближения, интересно взглянуть на крутизну линейного увеличения числа ошибок (параметр a2), т.e. скорость увеличения количества ошибок. Одна из интерпретаций параметра a2 заключается в том, что он дает дополнительное дробное значение числа жестких дисков, на которых появляются ошибки LSE при увеличении температуры на 1 градус, например, a2 = 0.01 означает, что при увеличении температуры на 1 градус еще на 1% жестких дисков в дата-центре будут появляться ошибки LSE в данном месяце. Мы узнали, что для 4 из 10 комбинаций моделей и дата-центров параметр a2, фактически, имеет небольшое отрицательное значение, показывающее небольшое уменьшение частоты ошибок вместе с ростом температуры. Для остальных положительных значений важно ставить значение a2 в зависимость от средней вероятности возникновения ошибок LSE на жестком диске (дается в третьей колонке Таблицы 1). При рассмотрении значений a2 в тех случаях, где они являются положительными, мы заметили, что a2 почти всегда как минимум на порядок меньше средней вероятности LSE для данной комбинации модели и дата-центра. Это значит, что доля жестких дисков, на которых возникнут ошибки LSE в результате повышения температуры на один градус, будет на порядок меньше среднего значения в массиве данных. Однако повышение температуры в ЦОД на десять градусов или более может требовать принятия некоторых чрезвычайных мер для защиты от потери данных в результате возникновения более частых ошибок LSE.

В дополнение к средней температуре, воздействию которой подвергается жесткий диск, еще одним важным фактором является изменчивость температуры, поскольку большие колебания температуры могут негативно отражаться на ИТ-оборудовании. Для изучения воздействия колебаний температуры на ошибки LSE мы построили график среднемесячных вероятностей возникновения LSE в зависимости от коэффициента изменчивости (CoV) 1 (см. Рис. 2). Мы выбрали CoV, а не дисперсию или среднеквадратичное отклонение, поскольку он делится на среднее значение. Положительная корреляция между ошибками LSE и температурной дисперсией как раз может быть обусловлена положительной корреляцией между ошибками LSE и средней температурой. На Рис. 2 показано явное увеличение вероятностей ошибок LSE вместе с увеличением CoV во всех моделях. Мы проверяли эти приближенные кривые, включая в линейную модель взаимосвязь LSE и CoV, и находя положительный спад a2 для всех пар моделей и дата-центров.

Вывод 2: Изменчивость температуры обычно имеет более выраженное и последовательное воздействие на частоту ошибок LSE, чем просто средняя температура.

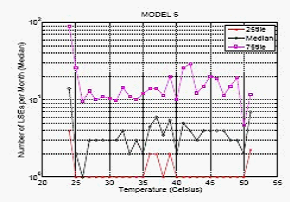

До сих пор наш анализ сосредотачивался исключительно на вероятности возникновения LSE на жестком диске. Другой интересным вопросом является возможность влияния более высокой температуры на увеличение количества ошибок LSE, если ошибки LSE возникают на жестком диске. Для ответа на этот вопрос на рисунке 3 показаны кривые дисков для месяцев, в которых ошибки находились в пределах 25-ой и 75-ой процентилей и среднее значение. Мы включили только результаты для модели 6, так как все остальные модели имеют сопоставимые кривые. Мы сосредотачивались на квартилях, а не на среднем значении, поскольку мы узнали, что среднее число ошибок LSE может быть очень непостоянным и, отсюда, легко отклоняться выскакивающими значениями. Мы заметили, что линия всех квартилей является ровной, и показывает, что жестки диски с ошибками, которые работают при более высокой температуре, имеют не большую частоту ошибок, чем жесткие диски с ошибками, которые работают при более низких температурах.

|

|

|

|

Рис. 3: Квартили числа LSEs для дисков с LSEs в зависимости от температуры. |

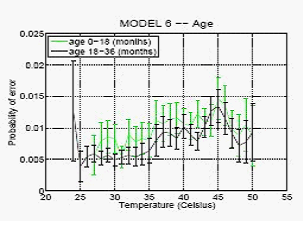

Рис. 4: Ежемесячная вероятность LSEs в зависиомти от температуры и периода эксплуатации диска. |

|

|

|

|

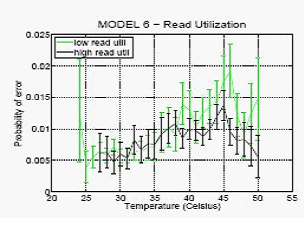

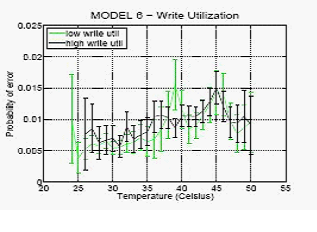

Рис. 5: Ежемесячная вероятность LSEs в зависимости от температуры для дисков с высокой и низкой нагрузками по записи (справа) и чтению (слева). |

|

Вывод 3: Более высокие температуры не приводят к увеличению ожидаемого количества ошибок LSE, если LSE возникают на диске, что может говорить о том, что причины возникновения ошибок LSE являются одинаковыми при высокой и при низкой температурах.

На рисунке 1 представлено еще одно интересное наблюдение: частота возникновения ошибок LSE в одной модели может значительно отличаться в разных центрах обработки данных. Например, в модели 3 в дата-центре 2 частота ошибок значительное выше, более чем в 2 раза, чем в остальных дата-центрах, а в модели 6 частота ошибок значительно выше в дата-центре 0, чем в остальных дата-центрах, опять же, более чем в 2 раза. Это вызывает вопрос о влиянии таких факторов как атмосферные условия, период и коэффициент использования жесткого диска на характер его реагирования на температуру. Хотя мы не располагаем данными по климатическим факторам, типа относительной влажности или качества электроэнергии, мы располагаем информацией по возрасту каждого диска и его коэффициенте использования и показали воздействие этих факторов на рисунках 4 и 5.

Показанные на рисунке 4 результаты исследования возраста и температуры основаны на модели 6, поскольку диски этой модели охватывают наиболее широкий диапазон возрастов. Мы разделили диски на две группы, с возрастом до 18 месяцев и с возрастом 18-36 месяцев и построили отдельные графики вероятностей возникновения ошибок LSE в зависимости от температуры для каждой группы. Мы узнали, что обе кривые линии показывают похожие закономерности, и нет никаких доказательств того, что более старые диски являются более чувствительными к повышенным температурам.

Вывод 4: В пределах 0-36 месяцев более старые диски в такой же степени подвержены риску появления ошибок LSE при повышении температуры, чем более новые диски.

На рисунке 5 показаны результаты изучения воздействия интенсивности рабочей нагрузки. На рисунке 5 слева диски делятся на две группы, с высокой и низкой нагрузками по чтению, и для каждой из этих двух групп построены отдельные графики вероятностей LSE.

Мы определяли нагрузку по чтению числом операций чтения в месяц и включали диск в группу с низкой нагрузкой по чтению, если число операций чтения было меньше средней величины для совокупности данных, и в группу с высокой нагрузкой по чтению — в противном случае. На рисунке 5 справа выполняется соответствующий анализ для нагрузки по записи. Результаты показаны только для модели 6, но другие модели также имели похожие закономерности.

Мы пришли к заключению, что диски с более высоким коэффициентом использования не являются более чувствительными к воздействию повышенных температур. Это результат интересен сам по себе, безотносительно к изучению воздействия температуры, так как вопрос о влиянии интенсивности рабочей нагрузки на LSE был открытым. Методы, которые предназначены для защиты от потерь данных, вызываемых ошибками LSE, типа периодических прогонов специальной программы («scrubber»), который считывает весь диск для упреждающего обнаружения LSE, могут увеличивать нагрузку на систему, и проблема в том, что эта дополнительная нагрузка может увеличивать частоту возникновения ошибок LSE. Наши результаты показывают, что подобные опасения, скорее всего, необоснованны.

Вывод 5: Высокий коэффициент использования не приводит к увеличению частоты LSE при повышенных температурах.

Для придания статистической строгости наблюдениям 4 и 5, мы выполнили тест ANOVA. Результаты не показали никакой корреляции между LSE и нагрузкой по записи. Есть признаки корреляции с нагрузкой по чтению и возрастом, однако, это обусловлено тем, что диски с меньшей нагрузкой по чтению и меньшим возрастом имеют немного повышенную частоту LSE.

2.2 Температура и отказы жесткого диска

2.2.1 Освещение проблемы и исходные данные

Неисправности жесткого диска включают любой вид проблем с диском, которые считаются достаточно серьезными для замены данного диска. Неисправности диска являются серьезными проблемами в ЦОД, поскольку они создают потенциальную возможность потери данных и случаются довольно частотой: как правило, 1-5% дисков в ЦОД необходимо заменять в году [26, 31]. До сих пор только одна работа — Pinheiro et al. [26], включала закономерности воздействия температуры на неисправности жесткого диска, основанные на данных полевых наблюдений. Как ни странно, в этой работе отмечено заметное снижение частоты неисправностей дисков вместе с ростом температуры, за исключением очень высоких температур (выше 45°C). Это находится в противоречии с общими моделями надежности, согласно которым частота неисправностей диска экспоненциально увеличивается вместе с температурой.

Целью этого раздела является пересмотр вопроса о воздействии температуры на частоту неисправностей жесткого диска. В дополнение к получению более исчерпывающего ответа на этот вопрос, мы также взглянули на этот вопрос под более широким углом, включив в свое исследование влияние коэффициента использования, различия моделей и дата-центров, а также возраст жесткого диска. В своем исследовании мы использовали данные по замене дисков, собранные в период с января 2007 г. до мая 2009 г. в 19 разных центрах обработки данных компании Google, охватывающих 5 разных моделей жестких дисков. По каждому диску мы располагали такими данными как: возраст диска, средняя температура и средний коэффициент использования за период наблюдения, полученными от SMART-системы диска, а также данными по замене диска в течение периода наблюдения. Хотя здесь использовался не такой период времени как в работе [26] (фактически, нет никого совпадения по времени), методология измерений и средства сбора данных аналогичным тем, которые использовались Google в своем исследовании.

Таблица 2: Параметры применения линейной и экспоненциальной моделей к ежемесячным неисправностям жесткого диска при изменении средней температуры.

Рис. 6: Ежемесячная вероятность отказа жесткого диска при изменении температуры по моделям диска.

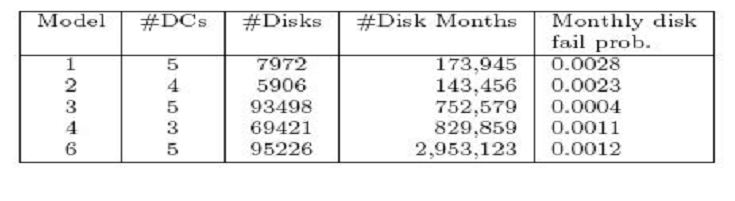

В приведенной ниже таблице даны некоторые обобщающие сведения.

2.2.2 Анализ

На Рис. 6 показана ежемесячная частота неисправностей для каждой из пяти моделей, усредненная для всех дата-центров. За исключением одной модели (модель 3), мы наблюдали повышение частоты неисправностей вместе с повышением температуры. Однако мы обратили внимание, что это повышение частоты неисправностей вместе с повышением температуры обычно имело линейный, а не экспоненциальный характер, за исключением очень высоких температур (выше 50°C). Мы проверили этот результат наблюдений путем применения линейной и экспоненциальной моделей к данным, используя методологию, описанную в параграфе 2.1. Результаты показаны в Таблице 2.

Поскольку спад кривых обычно изменяется при очень высоких температурах, мы также повторили анализ, включив только точки измерений ниже 50°C (см. правую половину Таблицы 2). Мы пришли к выводу, что во всех случаях линейная модель обеспечивает значительно большее приближение, чем экспоненциальная модель.

Как говорилось в параграфе 2.1, при рассмотрении повышения частоты неисправностей вместе с температурой (определяемой параметром a2) необходимо связывать величину повышения числа неисправностей со средней частотой отказов в системе. Рассматривая значения a2 в ходе применения линейной модели к точкам измерений ниже 50°C (см. Таблицу 2), мы обратили внимание на то, что в случае всех комбинаций модели и дата-центра значение a2 на два порядка меньше средней частоты отказов, за исключением одной точки измерений, модель 4, дата-центр 15. В то время как среднемесячная частота ежемесячных отказов, как правило, составляет порядка 0.1-0.2%, дополнительное число ожидаемых отказов жесткого диска при увеличении температуры на один градус составляет порядка одной тысячной процента.

Вывод 6: При температуре ниже 50°C, частота отказов дисков растет медленнее при изменении температуры, чем это предсказывается общими моделями. Как правило, этот рост имеет линейный, а не экспоненциальный характер и ожидаемое увеличение частоты отказов при увеличении температуры на один градус будет небольшим по сравнению с величиной существующих значений частоты отказов.

Также стоит отметить, что в отличие от исследования Google [26], мы не увидели общей тенденции более высоких значений частоты отказов при более низких температурах. Например, в исследовании Google сообщается о сокращении числа отказов более чем на 50% при повышении температуры с 25 до 35°C. Мы думаем, что причиной является объединение данных по разным моделям и дата-центрам в одной и той же кривой в [26]. Поскольку разные модели жестких дисков работают при разных температурах в связи с отличиями своей конструкции и в виду того, что разные модели жестких дисков могут также сильно отличаться своей частотой отказов, возможно, чтобы точки измерений в нижнем конце температурного спектра содержали большее число жестких дисков с более низкой рабочей температурой и более высокой частотой отказов, и, отсюда, отклонение результатов.

Как в случае ошибок LSE, мы пришли к выводу, что для одной модели среднемесячная вероятность отказов может значительно отличаться в разных дата-центрах, даже при одной и той же температуре. Полный список графиков отказов жестких дисков по дата-центрам включен в технический отчет [13]. Это свидетельствует о существовании других факторов, помимо температуры, которые могут иметь такое же или более сильное воздействие на сроки службы жестких дисков и побуждает нас рассматривать два возможных фактора, по которым у нас есть данные: возраст и коэффициент использования. Мы использовали такую же методологию как в случае LSE и разбили жесткие диски каждой модели по группам с высоким и низким коэффициентом использования, а также по возрасту. Мы пришли к заключению, что поведение жесткого диска под воздействием температуры не изменяется в зависимости от коэффициента использования или возраста при этом статистически значимые данные охватывают всего лишь 36 месяцев.

Вывод 7: Ни коэффициент использования, ни возраст жесткого диска не могут иметь значительного воздействия на его частоту отказов при изменении температуры.

Оригинал исследования размещен на сайте:

Ссылки в статье на источники:

[1] Operational Data to Support and Enable Computer Science Research, Los Alamos National Laboratory. http://institute.lanl.gov/data/fdata/.

[2] SciNet. http://www.scinet.utoronto.ca/.

[3] S. F. Altschul, W. Gish, W. Miller, E. W. Myers, and D. J. Lipman. Basic local alignment search tool. Journal of Molecular Biology, 215 (3):403–410, 1990.

[4] D. Anderson, J. Dykes, and E. Riedel. More than an interface—SCSI vs. ATA. In Proc. of FAST 2003.

[5] L. N. Bairavasundaram, G. R. Goodson, S. Pasupathy, and J. Schindler. An Analysis of Latent Sector Errors in Disk Drives. In Proc. of SIGMETRICS'07, 2007.

[6] C. Belady, A. Rawson, J. Pfleuger, and T. Cader. The Green Grid Data Center Power Efficiency Metrics: PUE & DCiE. Technical report, Green Grid, 2008.

[7] D. J. Bradley, R. E. Harper, and S. W. Hunter. Workload-based power management for parallel computer systems. IBM J.Res.Dev., 47:703–718, 2003.

[8] J. Brandon. Going Green In The Data Center: Practical Steps For Your SME To Become More Environmentally Friendly. Processor, 29, Sept. 2007.

[9] California Energy Commission. Summertime energy-saving tips for businesses. consumerenergycenter.org/tips/business summer.html.

[10] G. Cole. Estimating drive reliability in desktop computers and consumer electronics systems. TP-338.1. Seagate. 2000.

[11] H. J. Curnow, B. A. Wichmann, and T. Si. A synthetic benchmark. The Computer Journal, 19:43–49, 1976.

[12] A. E. Darling, L. Carey, and W. -c. Feng. The design, implementation, and evaluation of mpiblast. In In Proc. of ClusterWorld 2003, 2003.

[13] N. El-Sayed, I. Stefanovici, G. Amvrosiadis, A. A. Hwang, and B. Schroeder. Temperature management in data centers: Why some (might) like it hot. Technical Report TECHNICAL REPORT CSRG-615, University of Toronto, 2012.

[14] K. Flautner and T. Mudge. Vertigo: automatic performance-setting for linux. In Proc. of OSDI, 2002.

[15] A. Gandhi, M. Harchol-Balter, R. Das, and C. Lefurgy. Optimal power allocation in server farms. In Proc. of Sigmetrics '09, 2009.

[16] JEDEC Global Standards for the Microelectronics Industry. Arrhenius equation for reliability.

http://www.jedec.org/standards-documents/dictionary/terms/arrhenius-equation-reliability

[17] J. M. Kaplan, W. Forrest, and N. Kindler. Revolutionizing data center energy efficiency. Technical report, McKinsey & Company, July 2008.

[18] J. Katcher. Postmark: a new file system benchmark. Network Appliance Tech Report TR3022, Oct. 1997.

[19] Lawrence Berkeley National Labs. Benchmarking Data Centers. benchmarking-dc.html, December 2007.

[20] J. D. McCalpin. Memory bandwidth and machine balance in current high performance computers. IEEE Comp. Soc. TCCA Newsletter, pages 19–25, Dec. 1995.

[21] L. McVoy and C. Staelin. lmbench: portable tools for performance analysis. In Proc. of USENIX ATC, 1996.

[22] D. C. Niemi. Unixbench. http://www.tux.org/pub/tux/niemi/unixbench/.

[23] C. D. Patel, C. E. Bash, R. Sharma, and M. Beitelmal. Smart cooling of data centers. In Proc. of IPACK, 2003.

[24] M. Patterson. The effect of data center temperature on energy efficiency. In Proc. of ITHERM, May 2008.

[25] E. Pinheiro, R. Bianchini, E. V. Carrera, and T. Heath. Load balancing and unbalancing for power and performance in cluster-based systems, 2001.

[26] E. Pinheiro, W. D. Weber, and L. A. Barroso. Failure trends in a large disk drive population. In Proc. Of Usenix FAST 2007.

[27] S. J. Plimpton, R. Brightwell, C. Vaughan, K. Underwood, and M. Davis. A Simple Synchronous Distributed-Memory Algorithm for the HPCC RandomAccess Benchmark. In IEEE Cluster Computing, Sept. 2006.

[28] K. Rajamani and C. Lefurgy. On evaluating request-distribution schemes for saving energy in server clusters. In Proc. of the IEEE ISPASS, 2003.

[29] Rich Miller. Google: Raise your data center temperature. http://www.datacenterknowledge.com/archives/2008/10/14/google-raise-your-data-centertemperature/, 2008.

[30] B. Schroeder and G. Gibson. A large-scale study of failures in high-performance computing systems. In Proc. of DSN'06, 2006.

[31] B. Schroeder and G. A. Gibson. Disk failures in the real world: What does an MTTF of 1,000,000 hours mean to you? In Proc. of USENIX FAST, 2007.

[32] B. Schroeder, E. Pinheiro, and W. -D. Weber. DRAM errors in the wild: a large-scale field study. In Proc. Of SIGMETRICS '09, 2009.

[33] R. Sharma, C. Bash, C. Patel, R. Friedrich, and J. Chase. Balance of power: dynamic thermal management for internet data centers. IEEE Internet Computing, 9 (1):42–49, 2005.

[34] C. Staelin. Lmbench3: Measuring scalability. Technical report, HP Laboratories Israel, 2002.

[35] R. F. Sullivan. Alternating Cold and Hot Aisles Provides More Reliable Cooling for Server Farms. In Uptime Institute, 2000.

[36] T10 Technical Committee. SCSI Block Commands –3, Rev.25. Work. Draft T10/1799-D, ANSI INCITS.

[37] T13 Technical Committee. ATA 8 — ATA/ATAPI Command Set, Rev.4a. Work. Draft T13/1699-D, ANSI INCITS.

[38] Transaction Processing Performance Council. TPC Benchmark C — Rev. 5.11. Standard, Feb. 2010.

[39] Transaction Processing Performance Council. TPC Benchmark H — Rev. 2.14.2. Standard, June 2011.

[40] R. P. Weicker. Dhrystone: a synthetic systems programming benchmark. Communications of the ACM, 27 (10):1013–1030, Oct. 1984.

Сообщения, вопросы и ответы

Вы можете задать вопрос, написать комментарий, обсудить данную новость или статью.