Влияние температуры в центрах обработки данных на надежность. Часть 3

Помимо потенциального воздействия на надежность сервера, есть другие проблемы, связанные с повышением температуры в дата-центре. Повышение температуры могло бы отражаться на производительности серверов, повышать электропотребление серверов и приводить к снижению запаса прочности в случае отключения сети переменного тока или вентиляторов. В этой части раздела мы будем рассматривать все эти проблемы.

3.1 Температура и производительность

Хотя широко известно, что более высокие температуры могут отрицательно влиять на надежность и срок службы аппаратных устройств, меньше внимания уделяется тому факту, что высокие температуры могут также отрицательно сказываться на производительности систем. Например, для предупреждения возможного повышения частоты ошибок LSE некоторые модели жестких дисков включают функцию Read-after-Write (RaW) при достижении определенного порогового значения температуры. При RaW каждая операция записи на диск преобразовывается в команду Write Verify, или последовательные операции Write и Verify, которая выполняет чтение только что записанного сектора и проверка его содержимого [36, 37] 3. Также, когда температура CPU и запоминающего устройства достигает определенного порогового значения, в большинстве современных серверов используется регулирование запросов CPU (динамичное масштабирование частоты напряжения) и памяти (шины запоминающего устройства).

К сожалению, такие функции как RaW часто считаются коммерческой тайной и не документируются надлежащим образом. В действительности, даже в компании-производителе оборудования данные по этим функциям и связанным с ними параметрами считаются конфиденциальными и не выходят за пределы товарных групп. Целью этой части нашей работы является экспериментальное исследование характера влияния повышенной температуры на производительность различных компонентов.

3.1.1 Экспериментальная установка

Для исследования производительности серверов в условиях повышения температуры окружающей среды мы создали испытательный стенд с помощью термальной камеры. Термальная камера является достаточно большой для того чтобы вместить в себе целый сервер и позволяет нам регулировать температуру в диапазоне −10-60°C с точностью до 0.1°C. Влияние температуры окружающей среды на температуру внутренних компонентов сервера зависит от многих факторов, включая конструкцию системы охлаждения и сервера, а также архитектуру стойки. Поэтому, вместо непосредственного прогнозирования воздействия температуры воздуха в ЦОД на систему, мы представляем свои результаты в зависимости от температуры внутренних компонентов серверов.

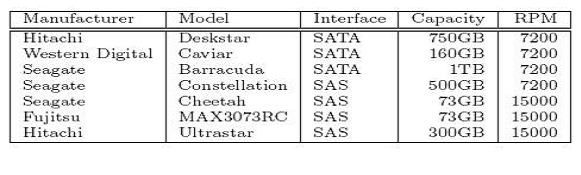

В своем исследовании мы использовали сервер Dell PowerEdge R710, модель, которая обычно используется в серверных стойках центров обработки данных. Сервер оборудован четырехядерным процессором 2.26 GHz Intel Xeon 5520 с кэшем 8MB L3, памятью 16GB DDR3 ECC, и работает под управлением ОС Ubuntu 10.04 Server на базе ядра 2.6.32-28-server Linux. Мы также оборудовали сервер большим числом разных приводов жестких дисков, которые включают технологии SAS и SATA и охватывают всех крупных производителей:

Мы использовали широкий диапазон рабочих нагрузок в своих экспериментах, в том числе набор синтетических микро тестов, предназначенных для тестирования разных частей системы, а также набор макро тестов, предназначенных для моделирования ряда реальных приложений:

-

STREAM: это микро тест для измерения полосы пропускания последовательных обращений к памяти [20]. Мы использовали реализацию из комплекта lmbench [21, 34] и измеряли производительность обращения к памяти размером 4 ГБ.

-

GUPS: это микро тест для измерения произвольных обращений к памяти, в миллиардах операций в секунду, определяемый набором тестов производительности HPC Challenge [27]. Мы тестировали производительность произвольных обращений к памяти размером 4 ГБ в форме блоков данных размером 8 килобит.

-

Dhrystone: хорошо известный микро тест, который используется для оценки производительности CPU по целочисленным операциям [40].

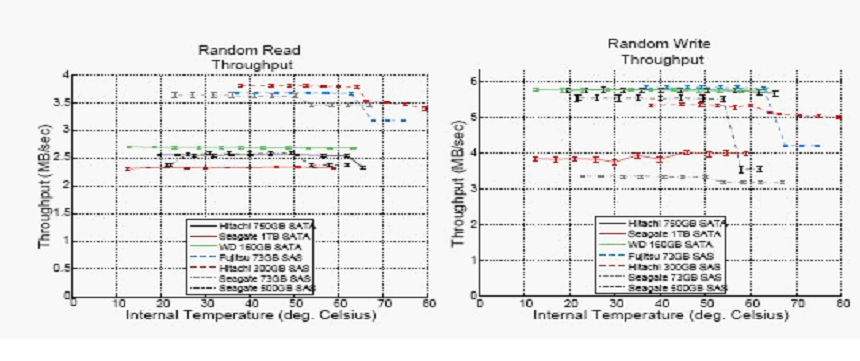

Рис. 14: Результаты измерения пропускной способности жесткого диска при синтетической нагрузке по произвольным операциям чтения и записи, соответственно, в зависимости от собственной температуры диска.

Измерения производительности последовательных операций чтения и записи имели сопоставимые результаты.

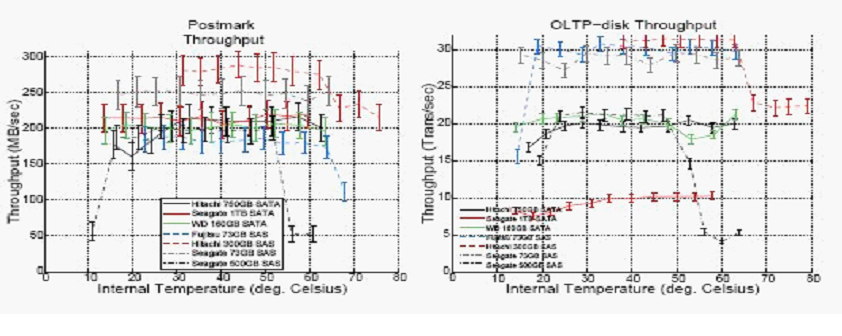

Рис. 15: Пропускная способность при двух разных рабочих нагрузках по интенсивности операций В/В (Postmark, OLTP-disk) в зависимости от собственной температуры жесткого диска.

-

Whetstone: хорошо известная программа тестирования производительности CPU по числам с плавающей точкой [11]. Свои реализации Dhrystone и Whetstone мы брали из комплекта Unixbench [22].

-

Random-Read/Write: синтетическая рабочая нагрузка, состоящая из независимых запросов на чтение или запись размером 64 килобит, непрерывно отправляемых в произвольные сектора диска.

-

Sequential-Read/Write: поскольку чистая последовательная (рабочая) нагрузка может вызывать нагрузку на внутридисковый кэш, мы решили использовать вместо нее синтетическую рабочую нагрузку с высокой степенью последовательности. Мы выбрали произвольный сектор диска и непрерывно отправляли запросы на чтение или запись размером 64 килобита в следующие друг за другом сектора размером 8 МБ после исходного запроса.

-

OLTP-Mem: мы включили в TPC-C [38], программу тестирования баз данных, широко используемую для моделирования онлайновой обработки транзакций (OLTP), 30 хранилищ метаданных, образующих постоянно находящуюся в ОЗУ базу данных размером 3 ГБ.

-

OLTP-Disk: используется для моделирования такой же нагрузки как OLTP-Mem. Для создания рабочей нагрузки с ограничениями В/В мы включили в базу данных 70 хранилищ метаданных (7gb), с помощью ПЗУ размером 4 ГБ RAM.

-

DSS-Mem: мы включили в TPC-H [39], широко применяемую программу тестирования баз данных, моделирующую системы поддержки принятия решений (DSS), постоянно находящуюся в ОЗУ базу данный MySQL InnoDB размером 1 ГБ.

-

DSS-Disk: другая рабочая нагрузка на базе TPC-H, которая в этот раз включает базу данных размером 10 ГБ и буферный пул размером 3.4 ГБ, образующие рабочую нагрузку с ограничениями В/В на диске.

-

PostMark [18]: общераспространенная программа тестирования файловой системы, которую мы настроили на генерирование файлов размером от 50 до 5000 килобайт, и предусмотрели в ней полный отказ от использования кэш-памяти ОС, для того чтобы все транзакции направлялись на диск.

-

BLAST [3]: приложение, которое применяется в вычислительной биологии для тестирования высокопроизводительных вычислительных систем и нагружает CPU и память. Мы использовали параллельную реализацию mpiBLAST [12] и выполнили 10 репрезентативных запросов библиотеки размером 5 ГБ.

3.1.2 Температура и производительность диска

Для изучения воздействия температуры на производительность диска мы выполняли свои программы тестирования производительности диска в условиях повышенной нагрузки на каждом жестком диске на своем испытательном стенде, помещая диски в термокамеру и постепенно увеличивая температуру внутри камеры. Два графика на Рис. 14 показывают результаты выполнения микро тестов произвольного чтения и записи, в зависимости от собственной температуры диска, показываемой статистикой системы SMART. (Результаты по последовательному чтению и записи были схожими и пропускаются в виду отсутствия достаточного места). Мы заметили, что на всех дисках SAS и на одном диске SATA (the Hitachi Deskstar) наблюдалось падение пропускной способности по причине высокой температуры. Обычно, это падение пропускной способности составляло порядка 5-10%, но иногда достигало 30%. В виду того факта, что падение пропускной способности диска постоянно происходило при одной и той же температуре, а не произвольно или постепенно, и что ни на одном из дисков не было никаких ошибок, мы полагаем, что это обусловлено включаемыми диском защитными механизмами. Например, в случае операций записи, при которых наблюдалось большее падение пропускной способности, это падение можно объяснить включением таких функций как RaW.

Возникает интересный вопрос: при какой температуре начинается падение производительности? Как показано на рисунке 14, падение производительности либо при температуре около 50°C (для дисков Seagate SAS), либо 60°C (для дисков Fujitsu и Hitachi SAS). Однако, это собственные температуры диска.

Если перевести их в температуру окружающего воздуха (внутри термокамеры), мы замечали падение производительности уже при температуре 40°C (для дисков Seagate 73GB и Hitachi SAS), 45°C (для дисков Fujitsu и Seagate 500GB SAS) и 55°C (для дисков Hitachi Deskstar), и это намного ниже рекомендуемой производителями максимальной рабочей температуры жестких дисков. Полный график сопоставления внутренних и внешних температур включен в технический отчет [13]. Хотя в центрах обработки данных средняя температура на входе оборудования редко когда достигает 40°C или выше, в большинстве дата центров есть горячие точки (см. параграф 3.3), где температура намного выше, чем в остальной части ЦОД, и вполне может достигать подобных значений.

На рисунке 15 показано воздействие температуры на производительность двух наших приложений с высокими требованиями к дисковым ресурсам, Postmark и OLTP-disk. Мы заметили похожие закономерности в этих микро тестах, где производительность падает при одной и той же температуре. Однако, величина потерянной производительности обычно является более высокой, как правило, порядка 10-20%, иногда достигает 40-80%. Падение производительности, наблюдавшееся в DSS-disk, было более похожим по величине на падение производительности при использовании синтетических программ тестирования.

3.1.3 Температура и производительность процессора и запоминающего устройства

Большинство серверов корпоративного класса поддерживают функции защиты CPU и подсистемы запоминающего устройства от повреждений или чрезмерного количества ошибок, вызываемых высокими температурами. Они включают плавное регулирование частоты CPU, снижение скорости передачи данных на шине памяти, а также использование современных программ исправления ошибок (ECC) в DRAM. Например, наши серверы поддерживали постоянный диапазон частот CPU, частоту шины равную 800 МГц или 1066 МГц, и три схемы защиты памяти: исправление одиночных ошибок и обнаружение двойных ошибок (SEC-DED), ECC повышенной сложности (AdvEcc), которая позволяет обнаруживать и исправлять ошибки большого числа бит, и зеркалирование, которое обеспечивает полную избыточность. Как правило, в руководствах по использованию серверов специально даются неясные сведения о времени включения подобных функций (сервер может автоматически включать функции регулирования (частоты) CPU и шины памяти), или возможном воздействии на производительность. В частности, трудно предсказать воздействие функций памяти на производительность и электропотребление. Поскольку эксплуатация дата-центров при повышенных температурах может вызывать необходимость в более частом использовании подобных функций, мы использовали свой испытательный стенд для изучения их воздействия на производительность и электропотребление.

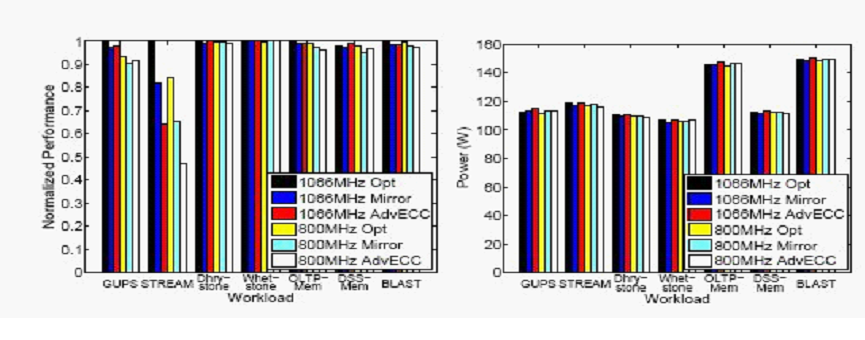

Рисунок 16: Воздействие функций исправления ошибок в памяти и регулирования частоты шины на производительность (слева) и электропотребление (справа).

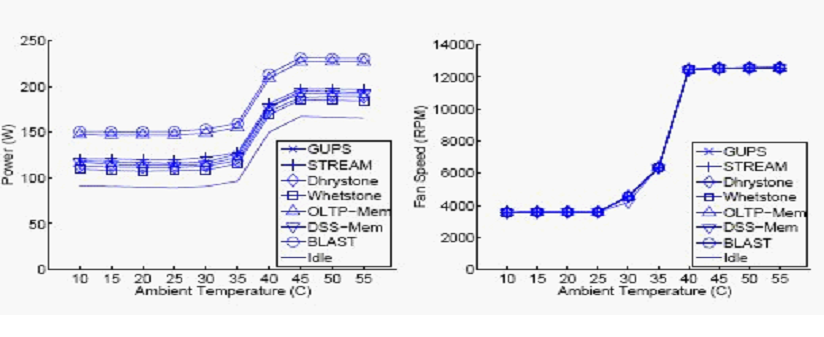

Рисунок 17: Воздействие температуры окружающего воздуха на электропотребление (слева) и частоту вращения серверных вентиляторов (справа).

В диапазоне температур, который мы использовали в своих экспериментах (температура внутри камеры достигала 55°C, что намного выше 35°C, номинальной температуры воздуха для большинства серверов) мы не заметили случав включения защитных функций сервером. Для изучения воздействия различных функций памяти мы вручную настраивали сервер на работу с разными комбинациями частоты шины памяти (800 МГц в сравнении с 1066 МГц) и схемами ECC (SEC-DED, AdvEcc, Mirror). Воздействие на производительность применения различных программ тестирования показано на рисунке 16 (слева). В качестве эталона производительности использовалась максимальная возможная производительность, т.e., производительность, достигаемая при использовании частоты шины 1066 МГц вместе с технологией SEC-DED ECC. Результаты использования двух микро программ тестирования предназначенных для моделирования нагрузки на память (GUPS и Stream), показали, что падение производительности может достигать громадных размеров. Переключение на более низкую частоту шины могло приводить к снижению производительности на 20%. Воздействие схемы ECC является еще большим: включение схемы AdvECC может стоить 40% производительности. Комбинированное использование функций может приводить к падению производительности более чем на 50%. В случае использования макро программ тестирования производительности, моделирующих работу реальных систем разность производительности может быть не настолько большой и не удивительно, но может достигать значительных уровней при 3–4%. Мы также измеряли электропотребление серверов рисунок 16 (справа), и пришли к выводу, что воздействие конфигураций памяти на электропотребление серверов является небольшим (1-3%), по сравнению с ростом электропотребления во время работы при повышенных температурах, которое рассматривается в следующем разделе.

3.2 Повышение электропотребления серверов

Повышение температуры воздуха на входе ИТ-оборудования может оказывать воздействие на рассеиваемую мощность оборудования. Многие производители ИТ-оборудования начинают увеличивать частоту оборотов встроенных охлаждающих вентиляторов при достижении температурой воздуха на входе оборудования определенного граничного значения с целью компенсации повышения температуры окружающего воздуха. Также, при повышении температуры увеличивается мощность утечки процессора, и может составлять значительную долю общего электропотребления процессора. Для изучения воздействия повышенной температуры на электропотребление сервера мы повторили все ранее выполнявшиеся эксперименты, подключив счетчик электроэнергии к серверу, в дополнение к мониторингу частоты оборотов вентиляторов.

На рисунке 17 (слева) показано электропотребление сервера в зависимости от температуры окружающего воздуха (термальная камера) для рабочих нагрузок требовательных к ресурсам CPU и памяти. В то время как абсолютная энергия, потребляемая различными рабочими нагрузками, сильно отличается, мы заметили одну общую для всех рабочих нагрузок закономерность: электропотребление остается без изменений до 30°C, а потом начинает непрерывно увеличиваться и стабилизируется при 40°C. Это повышение электропотребления является довольно значительным — до 50%.

Интересным вопросом является источник этого повышения электропотребления: увеличение числа оборотов вентиляторов (это сервер может регулировать) или увеличение рассеваемой мощности (это регулируется физическими законами). К сожалению, невозможно непосредственно измерять рассеиваемую мощность.

Тем не менее, есть твердое доказательство того, что главную роль в повышении электропотребления играют вентиляторы: на рисунке 17 (справа) показан график изменения числа оборотов вентиляторов в зависимости от температуры окружающего воздуха для экспериментов со всеми рабочими нагрузками. Мы заметили, что граничные значения температуры, при которых наблюдается увеличение числа оборотов вентиляторов, точно совпадают с температурами, при которых происходит повышение электропотребления. Мы также заметили, что электропотребление выравнивается одновременно с выравниванием числа оборотов вентиляторов, в то время как рассеиваемая мощность будет продолжать расти вместе с повышением температуры.

Вывод 11: при повышении температуры окружающего воздуха, вытекающее из него повышение электропотребления является значительным и главным образом связано с электропотреблением вентиляторов. Для сравнения, рассеиваемая мощность является пренебрежительно малой.

Интересный вывод заключатся в том, что электропотребление всех рабочих нагрузок начинает повышаться при одной и той же температуре окружающего воздуха, несмотря на то, что собственные температуры серверов могут сильно отличаться, и это означает, что причиной увеличения числа оборотов вентиляторов является температура окружающего воздуха, а не собственная температура. Например, температура ядра CPU более чем на 20°C выше в случае применения программ тестирования производительности BLAST и OLTP-Mem, по сравнению с большинством других рабочих нагрузок. Для большинства рабочих это означает, что собственные температуры серверов все еще являются довольно низкими (меньше 40°C), когда число оборотов вентиляторов начинает увеличиваться. В частности, мы заметили, что в случае сервера в режиме ожидания, измеренная температура CPU и памяти по-прежнему является очень скромной, и составляет порядка 25-30°C, когда число оборотов вентиляторов начинает увеличиваться. Технический отчет [13] содержит подробные графики температур CPU и памяти для всех рабочих нагрузок. Это важный вывод, так как большинство серверов в дата-центрах большую часть своего срока службы проводят в режиме ожидания.

Вывод 12: для того чтобы эксплуатировать дата-центры при более высоких температурах, следует обязательно использовать интеллектуальные средства регулирования частоты оборотов серверных вентиляторов. Значительную долю наблюдавшегося в наших экспериментах повышения рассеиваемой мощности можно было бы избежать с помощью более сложных алгоритмов регулирования числа оборотов вентиляторов.

3.3 Снижение запаса прочности

Одна из проблем повышения температуры в ЦОД заключается в том, что в большинстве дата-центров, как правило, есть горячие точки, температура которых намного превышает среднюю температуру в здании. При повышении заданного значения температуры в системе охлаждения дата-центра необходимо прежде всего думать о том, как это может отразиться на местах системы с самыми высокими температурами, а не только о местах со средней температурой. Кроме горячих точек, еще одной проблемой является снижение запаса прочности: в большинстве серверов установлено граничное значение критической температуры, при достижении которого они будут выключаться, для того чтобы избежать серьезных повреждений оборудования.

При повышении температуры воздуха в дата-центре рабочая температура оборудования будет приближаться к максимальному допустимому значению, и тем самым сокращать время на правильное выключение серверов или принятие защитных мер в случае аварийных ситуаций в дата-центре, типа отключения сети электропитания переменного тока или отказа вентиляторов.

С целью улучшения понимания нарушения температурного равновесия мы проанализировали разности температур в дата-центрах в своих совокупностях данных. Мы рассмотрели разброс температур дисков в разных дата-центрах Google (с помощью совокупности данных из параграфа 2.1) и температур узлов в системе LANL 20 (с помощью совокупности данных из параграфа 2.3). Мы рассматривали, насколько выше была температура диска или узла в 95-ой и 99-ой процентили распределения в дата-центре, по сравнению со средним диском или узлом.

Примечательно, что закономерности нарушения температурного равновесия являются очень схожими в разных дата центрах, несмотря на то, что в их проектировании и управлении принимали участие разные организации. Мы заметили, что для всех центров обработки данных Google, принимавших участие в нашем исследовании, а также системы LANL 20, в 95-ой процентили температура узла или диска была приблизительно на 5°C выше средней температуры узла или диска, а в 99-ой процентили – приблизительно на 8–10 градусов выше средней температуры узла или диска. Технический отчет [13] включает полные CDF распределения по узлам или дискам.

Вывод 13: величина в градусах)изменения температуры узлов в дата-центрах является удивительно схожей для всех дата-центров в нашем исследовании. Как правило, температура 5% самых горячих узлов не менее чем на 5°C выше температуры стандартного узла, в то время как температура 1% самых горячих узлов не менее чем 8–10°C выше.

4. ЗАКЛЮЧЕНИЕ И ВЫВОДЫ

Повышение температуры в ЦОД создает потенциальную возможность большой экономии электроэнергии и сокращения выбросов углекислого газа. К сожалению, трудности, которые могут быть связаны с повышением температуры в дата центре, не до конца изучены, и в результате этого большинство дата-центров работает при очень консервативных, низких уровнях температуры. Эта работа проливает некоторый свет на проблемы, которые могут возникать в связи с повышением температур в дата-центре, и дает некоторые удивительные выводы.

Основываясь на результатах анализа данных, которые охватывают более одного десятка центров обработки данных трех разных организаций, и включают широкий диапазон проблем с надежностью, мы пришли к выводу, что воздействие высокой температуры в дата-центре на надежность системы является меньшим, чем это часто предполагают. По некоторым из изучавшихся нами проблем надежности, а именно отказы DRAM и перебои в работе узлов, мы не нашли никаких подтверждений корреляции с повышенной температурой в пределах использовавшегося нами диапазона температур. В случае неисправностей, которые показывают корреляцию ошибки в скрытых секторах дисков и отказы дисков, эта корреляция намного слабее ожидаемой. При температурах внутри устройств ниже 50°C, увеличение числа ошибок вместе с температурой, как правило, имеет линейный, а не экспоненциальный характер, как показывают существующие модели.

Необходимо отметить, что это не означает, что высокие температуры не имеют никакого воздействия на надежность оборудования, или что уравнение Аррениуса является неправильным. Но это может означать, что на интенсивность отказов влияют другие факторы. В уравнении Аррениуса включается только воздействие тепла на аппаратные компоненты и не принимаются во внимание другие факторы, которые могут воздействовать на надежность оборудования в условиях эксплуатации.

Например, данные, получаемые во время бесед с операторами дата-центров, показывают, что плохое обслуживание оборудования может быть важным фактором в условиях эксплуатации и это трудно заметить в результатах измерений.

Наши результаты показывают, что, с учетом всех факторов, воздействие температуры на надежность оборудования в действительности слабее, чем обычно думают.

Мы также пришли к выводу, что более важным фактором может быть изменчивость температуры, а не средняя температура. Даже неисправности, которые не показывают корреляции с температурой, типа перебоев в работе узлов, показывают явную корреляцию с изменчивостью температуры. Меры по контролированию таких факторов могут быть более важными для обеспечения низкого уровня аппаратных отказов, чем поддержание низкого уровня температуры.

Мы также сделали некоторые наблюдения, которые могут быть полезными для предупреждения проблем с оборудованием, вызываемых температурой. Ошибки в скрытых секторах жесткого диска (LSE) представляет собой вид неисправности, которая в наибольшей степени была связана с температурой. Общераспространенные методы защиты от потери данных, обусловленной LSE, включают функцию Read-after-Write и периодическое «сканирование» жесткого диска с целью заблаговременного обнаружения таких ошибок. В экспериментах с термокамерой мы нашли подтверждение тому, что в жестких дисках промышленного класса действительно используются такие механизмы как RaW, но мы пришли к выводу, что они, как правило, включаются только при очень высоких температурах и при этом могут оказывать серьезное воздействие на производительность. С другой стороны, мы также пришли к выводу, что одним из опасений, часто связываемых со сканированием диска, на практике не подтверждается, что может сделать сканирование лучшим методом защиты от LSE: некоторые боялись, что дополнительная нагрузка на диск, оказываемая сканированием, может приводить к быстрому износу диска, но мы не заметили никакой зависимости между интенсивностью работы диска и вероятностью его отказов.

Полученные нами обнадеживающие результаты исследования воздействия температуры на надежность оборудования смещают центр внимания на другие потенциальные проблемы повышения температуры в дата-центрах. Одной такой проблемой является повышение электропотребления отдельных серверов при повышении температуры воздуха на входе оборудования. Двумя часто приводимыми причинами такого повышения являются повышение рассеиваемой мощности процессора и частоты оборотов, встроенных в сервер вентиляторов. Результаты наших экспериментов показали, что рассеиваемая мощность является пренебрежительно малой, по сравнению с воздействием серверных вентиляторов. В сущности, мы пришли к выводу, что даже при относительно низкой температуре окружающего воздуха (порядка тех, которые обычно наблюдаются в более жарких зонах в остальных отношениях прохладного дата-центра) электропотребление вентиляторов составляет значительную долю общего электропотребления. Большая часть этой энергии может расходоваться нерационально, в связи с плохо продуманными алгоритмами регулирования частоты оборотов вентиляторов.

Мы могли бы чересчур упростить проблему, если бы мы попытались дать обобщенные рекомендации или прогнозы относительно того, какой именно должна быть температура в ЦОД и сколько энергии можно сэкономить. Ответ на эти вопросы будет зависеть от слишком большого числа факторов, которые могут быть уникальными для дата-центра или приложения. Однако мы считаем полученные нами результаты надежным подтверждением того, что большинство организаций могут эксплуатировать свои дата-центры при более высоких температурах, чем сейчас без серьезного ущерба для надежности. Мы надеемся, что эта работа будет стимулировать проведение в будущем других исследований в этой области и поощрять большее число организаций делится данными полевых наблюдений или результатами анализа своих дата-центров.

Оригинал исследования размещен на сайте: .

Ссылки на источники:

[1] Operational Data to Support and Enable Computer Science Research, Los Alamos National Laboratory. http://institute.lanl.gov/data/fdata/.

[2] SciNet. http://www.scinet.utoronto.ca/.

[3] S. F. Altschul, W. Gish, W. Miller, E. W. Myers, and D. J. Lipman. Basic local alignment search tool. Journal of Molecular Biology, 215 (3):403–410, 1990.

[4] D. Anderson, J. Dykes, and E. Riedel. More than an interface—SCSI vs. ATA. In Proc. of FAST 2003.

[5] L. N. Bairavasundaram, G. R. Goodson, S. Pasupathy, and J. Schindler. An Analysis of Latent Sector Errors in Disk Drives. In Proc. of SIGMETRICS'07, 2007.

[6] C. Belady, A. Rawson, J. Pfleuger, and T. Cader. The Green Grid Data Center Power Efficiency Metrics: PUE & DCiE. Technical report, Green Grid, 2008.

[7] D. J. Bradley, R. E. Harper, and S. W. Hunter. Workload-based power management for parallel computer systems. IBM J.Res.Dev., 47:703–718, 2003.

[8] J. Brandon. Going Green In The Data Center: Practical Steps For Your SME To Become More Environmentally Friendly. Processor, 29, Sept. 2007.

[9] California Energy Commission. Summertime energy-saving tips for businesses. consumerenergycenter.org/tips/business summer.html.

[10] G. Cole. Estimating drive reliability in desktop computers and consumer electronics systems. TP-338.1. Seagate. 2000.

[11] H. J. Curnow, B. A. Wichmann, and T. Si. A synthetic benchmark. The Computer Journal, 19:43–49, 1976.

[12] A. E. Darling, L. Carey, and W. -c. Feng. The design, implementation, and evaluation of mpiblast. In In Proc. of ClusterWorld 2003, 2003.

[13] N. El-Sayed, I. Stefanovici, G. Amvrosiadis, A. A. Hwang, and B. Schroeder. Temperature management in data centers: Why some (might) like it hot. Technical Report TECHNICAL REPORT CSRG-615, University of Toronto, 2012.

[14] K. Flautner and T. Mudge. Vertigo: automatic performance-setting for linux. In Proc. of OSDI, 2002.

[15] A. Gandhi, M. Harchol-Balter, R. Das, and C. Lefurgy. Optimal power allocation in server farms. In Proc. of Sigmetrics '09, 2009.

[16] JEDEC Global Standards for the Microelectronics Industry. Arrhenius equation for reliability.

http://www.jedec.org/standards-documents/dictionary/terms/arrhenius-equation-reliability

[17] J. M. Kaplan, W. Forrest, and N. Kindler. Revolutionizing data center energy efficiency. Technical report, McKinsey & Company, July 2008.

[18] J. Katcher. Postmark: a new file system benchmark. Network Appliance Tech Report TR3022, Oct. 1997.

[19] Lawrence Berkeley National Labs. Benchmarking Data Centers. benchmarking-dc.html, December 2007.

[20] J. D. McCalpin. Memory bandwidth and machine balance in current high performance computers. IEEE Comp. Soc. TCCA Newsletter, pages 19–25, Dec. 1995.

[21] L. McVoy and C. Staelin. lmbench: portable tools for performance analysis. In Proc. of USENIX ATC, 1996.

[22] D. C. Niemi. Unixbench. http://www.tux.org/pub/tux/niemi/unixbench/.

[23] C. D. Patel, C. E. Bash, R. Sharma, and M. Beitelmal. Smart cooling of data centers. In Proc. of IPACK, 2003.

[24] M. Patterson. The effect of data center temperature on energy efficiency. In Proc. of ITHERM, May 2008.

[25] E. Pinheiro, R. Bianchini, E. V. Carrera, and T. Heath. Load balancing and unbalancing for power and performance in cluster-based systems, 2001.

[26] E. Pinheiro, W. D. Weber, and L. A. Barroso. Failure trends in a large disk drive population. In Proc. Of Usenix FAST 2007.

[27] S. J. Plimpton, R. Brightwell, C. Vaughan, K. Underwood, and M. Davis. A Simple Synchronous Distributed-Memory Algorithm for the HPCC RandomAccess Benchmark. In IEEE Cluster Computing, Sept. 2006.

[28] K. Rajamani and C. Lefurgy. On evaluating request-distribution schemes for saving energy in server clusters. In Proc. of the IEEE ISPASS, 2003.

[29] Rich Miller. Google: Raise your data center temperature. http://www.datacenterknowledge.com/archives/2008/10/14/google-raise-your-data-centertemperature/, 2008.

[30] B. Schroeder and G. Gibson. A large-scale study of failures in high-performance computing systems. In Proc. of DSN'06, 2006.

[31] B. Schroeder and G. A. Gibson. Disk failures in the real world: What does an MTTF of 1,000,000 hours mean to you? In Proc. of USENIX FAST, 2007.

[32] B. Schroeder, E. Pinheiro, and W. -D. Weber. DRAM errors in the wild: a large-scale field study. In Proc. Of SIGMETRICS '09, 2009.

[33] R. Sharma, C. Bash, C. Patel, R. Friedrich, and J. Chase. Balance of power: dynamic thermal management for internet data centers. IEEE Internet Computing, 9 (1):42–49, 2005.

[34] C. Staelin. Lmbench3: Measuring scalability. Technical report, HP Laboratories Israel, 2002.

[35] R. F. Sullivan. Alternating Cold and Hot Aisles Provides More Reliable Cooling for Server Farms. In Uptime Institute, 2000.

[36] T10 Technical Committee. SCSI Block Commands –3, Rev.25. Work. Draft T10/1799-D, ANSI INCITS.

[37] T13 Technical Committee. ATA 8 — ATA/ATAPI Command Set, Rev.4a. Work. Draft T13/1699-D, ANSI INCITS.

[38] Transaction Processing Performance Council. TPC Benchmark C — Rev. 5.11. Standard, Feb. 2010.

[39] Transaction Processing Performance Council. TPC Benchmark H — Rev. 2.14.2. Standard, June 2011.

[40] R. P. Weicker. Dhrystone: a synthetic systems programming benchmark. Communications of the ACM, 27 (10):1013–1030, Oct. 1984.

Сообщения, вопросы и ответы

Вы можете задать вопрос, написать комментарий, обсудить данную новость или статью.